强化学习基础和马尔科夫决策过程

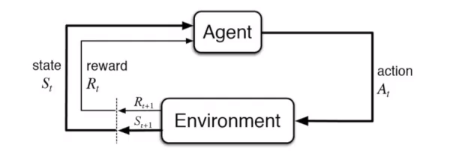

强化学习基本过程

强化学习基本要素

- 模型

- 政策

- 价值

深度学习不同点

- 没有标签,只有反馈

- 学习的过程来自于试错

- 学习的反馈有延迟

- 动作会影响数据

- 观察数据有时间的关联

马尔科夫基本过程(MDP)

马尔科夫过程的下一状态只取决于当前状态

马尔科夫奖励过程

- S:state

- R: Reward,

- Discount factor

- P:dynamics/transition model

Horizon

- Number of maximum time steps in each episode

- Can be infinite,otherwise called finite Markov (reward) Process

Return

可以看出随着时间变化,奖励值会衰减,只有离开某个状态才能获得奖励,所以奖励来自于未来的状态

state value function Vt(s) for a MRP

Expected

Discount Factor

可以作为强化学习的超参数调整

- 当

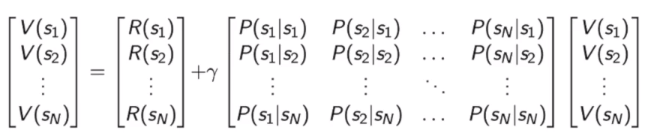

Bellman equation

Bellman方程描述了状态的迭代关系

矩阵求逆的计算量太大,所以我们一般用迭代的方法求解

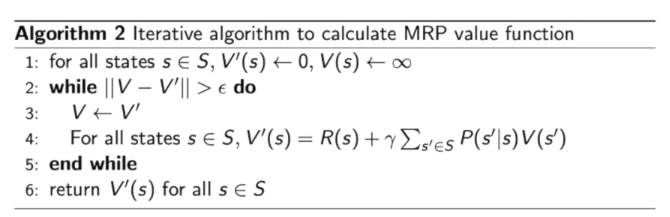

- 动态规划法

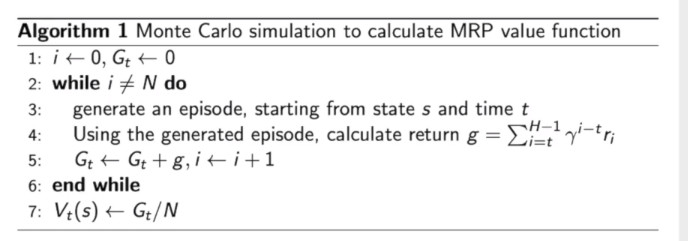

- 蒙特卡洛采样法

- Temporal-Difference learning

蒙特卡洛法

动态规划

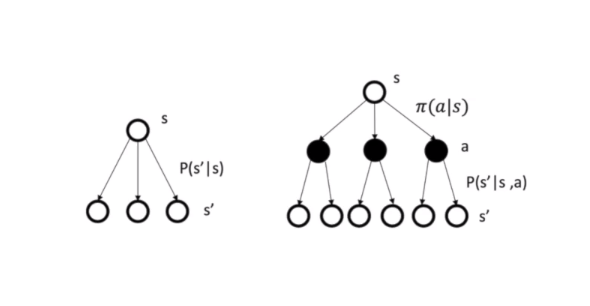

马尔科夫决策过程

增加了一个动作

- S:state

- A: action

- R: Reward,

- Discount factor

- P:dynamics/transition model

Policy

- policy决定了当前采取的策略

- Policy:

- Policies are stationary (time-independent),

- Given an MDP

- The state sequence S1, S2,… is a Markov process

- The state and reward sequence S1,R2,S2, R2,… is a Markov reward

process (S, PT,R”, ) where,

当policy

已知时,马尔科夫决策过程会转化为马尔科夫奖励过程

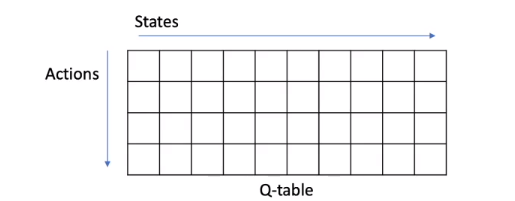

State Value Function

action-value function

状态价值函数和动作价值函数的关系

Bellman Equation

表示了采用policy 得到奖励的期望

马尔科夫决策过程的预测和控制

- 预测

- 预测价值

- 控制

- 寻找最佳策略

predition

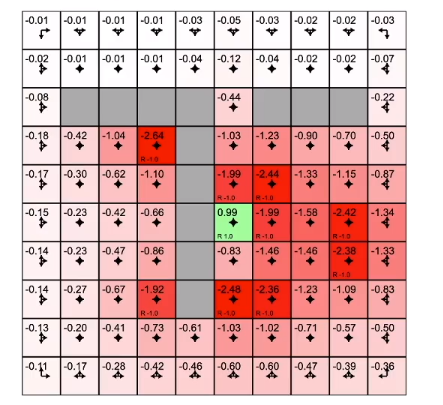

optimal value function and policy

如何寻找最佳的policy?

最佳行为可以定义为

policy search

策略搜索的方法主要有以下两种

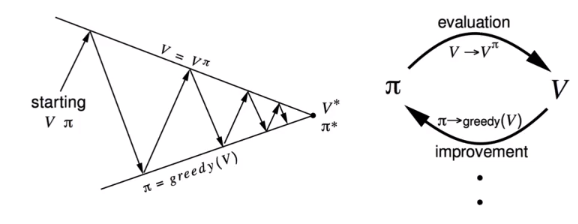

policy iteration

策略迭代算法有两个步骤

- 估计当前政策价值函数

- 采用贪心算法改进策略

policy improvwment

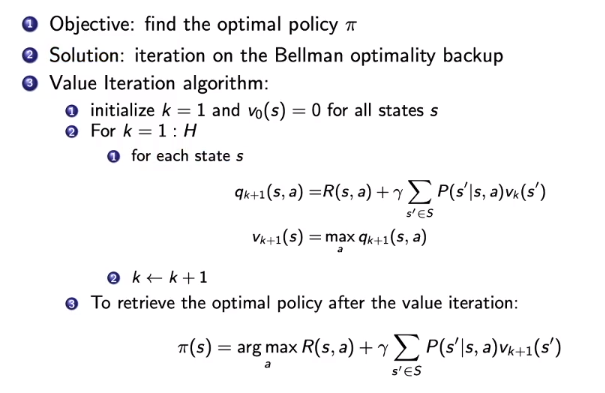

value iteration

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 摸黑干活!

评论